商務信息咨詢項目如何選擇 五大必知大數據處理框架技術對比分析

在當今數據驅動的商業環境中,商務信息咨詢項目能否高效處理海量數據,直接決定了洞察的深度與決策的準確性。面對眾多大數據處理框架技術,如何選擇最適合自身項目的工具,成為咨詢團隊的核心考量。本文將深入剖析五種主流大數據處理框架技術,并從商務信息咨詢的應用場景出發,為您提供清晰的選型指南。

一、五大必知大數據處理框架技術概覽

- Apache Hadoop:作為大數據領域的基石,Hadoop以其分布式文件系統(HDFS)和MapReduce計算模型聞名。它擅長離線批處理,適合處理歷史業務數據、生成周期性報告,例如對過去一年的市場趨勢進行宏觀分析。

- Apache Spark:憑借內存計算優勢,Spark在批處理、流處理及機器學習等領域表現卓越。其速度遠超Hadoop,適合需要實時或近實時分析的場景,如動態監測市場輿情、快速驗證商業假設。

- Apache Flink:作為真正的流處理框架,Flink支持事件驅動型應用,可實現極低延遲的數據處理。對于需要即時響應的咨詢項目,如金融風險實時監控或供應鏈異常檢測,Flink是理想選擇。

- Apache Kafka:嚴格而言,Kafka是一個分布式事件流平臺,常作為數據管道用于高吞吐量的實時數據集成。在咨詢項目中,它可用于連接多源數據(如CRM、社交媒體),確保數據流動的可靠性與時效性。

- 云原生服務(如AWS EMR、Google BigQuery):各大云平臺提供的托管服務,降低了運維復雜度。對于資源有限或追求敏捷的咨詢團隊,這些服務能快速部署,靈活伸縮,適合短期或試點項目。

二、商務信息咨詢項目的選型關鍵因素

- 數據特性:

- 若數據以靜態歷史數據為主(如年度財務審計),Hadoop或Spark批處理模式更為經濟。

- 若涉及高速流數據(如實時交易日志),應優先考慮Flink或Spark Streaming。

- 業務時效性要求:

- 對實時決策依賴強的項目(如競爭情報動態分析),需采用Flink或Kafka+Spark組合。

- 對時效要求寬松的深度分析(如行業長期趨勢預測),Hadoop或Spark批處理已足夠。

- 團隊技術能力:

- Hadoop生態成熟但學習曲線陡峭,適合有深厚技術積淀的團隊。

- 云原生服務簡化了運維,更適合技術資源緊張或追求快速迭代的咨詢團隊。

- 成本與可擴展性:

- 自建集群(如Hadoop/Spark)前期投入大,但長期定制性強。

- 云服務按需付費,適合業務量波動大的咨詢項目,能有效控制成本。

三、實戰選型建議:匹配咨詢場景

- 場景一:市場進入策略咨詢

需要整合多年行業數據與宏觀經濟指標,進行批量建模分析。推薦使用Spark,平衡處理效率與復雜性,并借助MLlib庫進行預測分析。

- 場景二:客戶體驗實時優化咨詢

需處理來自網站、APP的實時用戶行為數據,即時識別痛點。推薦采用Kafka收集數據流,由Flink進行實時處理與告警,實現秒級洞察。

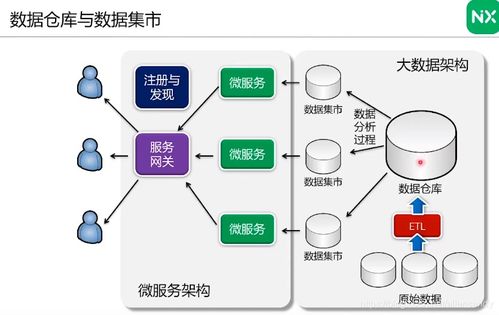

- 場景三:規模化數據平臺建設咨詢

為企業客戶設計長期數據架構時,可結合Hadoop(存儲與批處理基礎)與Spark(高性能計算),構建混合框架以應對多樣化需求。

- 場景四:敏捷型專項咨詢

項目周期短、需求多變,建議直接采用云服務(如BigQuery),無需基礎設施管理,專注分析邏輯與交付速度。

商務信息咨詢項目選擇大數據處理框架時,應摒棄“技術至上”思維,緊密圍繞業務目標、數據特質與資源約束進行權衡。對于多數咨詢團隊,從Spark入手是一個穩健的起點,它在性能、生態與學習成本間取得了良好平衡。隨著項目深入,可逐步引入Kafka、Flink等組件構建混合架構,最終形成貼合自身業務流的數據處理能力,從而在數據洪流中提煉出真正驅動商業價值的決策智慧。

如若轉載,請注明出處:http://www.pacoherrero.cn/product/45.html

更新時間:2026-01-18 07:14:00